Når marketingfolk som os opretter destinationssider, skriver e-mail-kopi eller designer opfordringsknapper, kan det være fristende at bruge vores intuition til at forudsige, hvad der får folk til at klikke og konvertere.

Men at basere markedsføringsbeslutninger ud fra en “følelse” kan være ret skadeligt for resultaterne. I stedet for at stole på gæt eller antagelser for at træffe disse beslutninger , er det meget bedre for dig at køre en A / B-test – undertiden kaldes en split-test.

A / B-test kan være værdifuldt, fordi forskellige målgrupper opfører sig godt, forskelligt. Noget, der fungerer for et firma, fungerer muligvis ikke for et andet. Faktisk hader eksperter på optimering af konverteringsfrekvens (CRO) udtrykket “bedste praksis”, fordi det faktisk ikke er den bedste praksis for dig.

Men A / B-test kan også være komplekse. Hvis du ikke er forsigtig, kan du antage forkerte antagelser om, hvad folk kan lide, og hvad der får dem til at klikke – beslutninger, der let kan misinformere andre dele af din strategi.

Fortsæt læsning for at lære, hvordan man gør A / B test før, under og efter dataindsamling, så du kan tage de bedste beslutninger ud fra dine resultater.

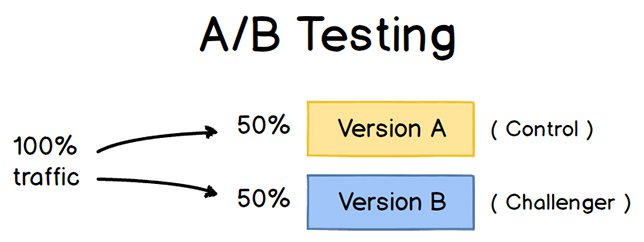

For at køre en A / B-test skal du oprette to forskellige versioner af et stykke indhold med ændringer til en enkelt variabel. Derefter vil du vise disse to versioner til to målgrupper af samme størrelse og analysere, hvilken af dem, der klarede sig bedre over en bestemt periode (længe nok til at træffe nøjagtige konklusioner om dine resultater).

Kilde

A / B-test hjælper marketingfolk med at observere, hvordan en version af et stykke marketingindhold fungerer sammen med et andet. Her er to typer A / B-tests, du kan udføre i et forsøg på at øge dit websteds konverteringsfrekvens:

Eksempel 1: Test af brugeroplevelse

Måske vil du se om ved at flytte en bestemt CTA-knap (Call-to-Action) til toppen af din startside i stedet for at holde den i sidepanelet, forbedres dens klikfrekvens.

At A / B teste denne teori, du ” d oprette en anden, alternativ webside, der afspejler ændringen af CTA-placeringen. Det eksisterende design – eller “kontrol” – er version A. Version B er “udfordrer.” Derefter testede du disse to versioner ved at vise hver af dem for en forudbestemt procentdel af webstedsbesøgende. Ideelt set er procentdelen af besøgende, der ser begge versioner, den samme.

Lær, hvordan man let A / B-test en komponent på dit websted med HubSpots Marketing Hub.

Eksempel 2: Designtest

Måske vil du finde ud af, om du ændrer farven på din opfordring til handling (CTA ) -knappen kan øge dens klikfrekvens.

For at A / B teste denne teori skulle du designe en alternativ CTA-knap med en anden knapfarve, der fører til den samme destinationsside som kontrolelementet. Hvis du bruger normalt en rød opfordring til handling-knap i dit marketingindhold, og den grønne variation modtager flere klik efter din A / B-test, dette kan fortjene at ændre standardfarven på dine opfordringsknapper til grøn fra nu af .

For at lære mere om A / B-test, download vores gratis introduktionsvejledning her.

Fordelene ved A / B-test

A / B-test har en lang række fordele for en mor Afhængigt af hvad det er, beslutter du at teste. Frem for alt er disse tests dog værdifulde for en virksomhed, fordi de har lave omkostninger, men høje belønninger.

Lad os sige, at du ansætter en indholdsskaber med en løn på $ 50.000 / år. Denne indholdsskaber udgiver fem artikler om ugen til firmaets blog, i alt 260 artikler om året. Hvis det gennemsnitlige indlæg på virksomhedens blog genererer 10 kundeemner, kan du sige, at det koster lidt over $ 192 at generere 10 kundeemner til virksomheden ($ 50.000 løn ÷ 260 artikler = $ 192 pr. Artikel). Det er en solid del af forandringen.

Hvis du nu beder denne indholdsskaber om at bruge to dage på at udvikle en A / B-test på en artikel, i stedet for at skrive to artikler i denne periode, kan du brænde $ 192, fordi du offentliggør en færre artikel . Men hvis A / B-testen finder ud af, at du kan øge hver artikels konverteringsfrekvens fra 10 til 20 kundeemner, har du lige brugt $ 192 til potentielt at fordoble antallet af kunder, din virksomhed får fra din blog.

Hvis testen mislykkes naturligvis, du tabte $ 192 – men nu kan du gøre din næste A / B-test endnu mere uddannet. Hvis den anden test lykkes med at fordoble din blogs konverteringsfrekvens, brugte du i sidste ende 284 $ til potentielt at fordoble din virksomheds indtægter. Uanset hvor mange gange din A / B-test mislykkes, vil dens eventuelle succes næsten altid opveje omkostningerne ved at gennemføre den.

Det komplette A / B-testkit til marketingfolk

Udfyld denne formular for at få dit kit.

Der er mange typer split-tests, du kan køre for at gøre eksperimentet det værd i sidste ende.Her er nogle fælles mål, som marketingfolk har for deres forretning, når A / B-test:

- Øget trafik på websitet: Test af forskellige blogindlæg eller websitetitler kan ændre antallet af personer, der klikker på den hyperlinkede titel til komme til dit websted. Dette kan øge websitetrafikken som et resultat.

- Højere konverteringsfrekvens: Test af forskellige placeringer, farver eller endda forankringstekst på dine CTAer kan ændre antallet af personer, der klikker på disse CTAer for at komme til en destinationsside. Dette kan øge antallet af personer, der udfylder formularer på dit websted, indsender deres kontaktoplysninger til dig og “konvertere” til et kundeemne.

- Lavere afvisningsprocent: Hvis dine besøgende på webstedet forlader (eller “afvis “) hurtigt efter at have besøgt dit websted, kan test af forskellige blogindlæg, skrifttyper eller funktionsbilleder reducere denne afvisningsfrekvens og fastholde flere besøgende.

- Nedre indkøbsvognefterladelse: E-handelsvirksomheder ser 40-75% af kunderne forlader deres hjemmeside med varer i deres indkøbskurv, ifølge MightyCall. Dette er kendt som “nedlæggelse af indkøbskurv.” Test af forskellige produktbilleder, design af udtjekningssider, og selv hvor forsendelsesomkostninger vises, kan sænke denne opgørelsesrate.

Lad os nu gennemgå tjeklisten til opsætning, kørsel, og måling af en A / B-test.

Sådan gennemføres A / B-test

Følg med med vores gratis A / B-testkit med alt hvad du behøver for at køre A / B-test, herunder en testsporingsskabelon, en vejledningsvejledning til instruktion og inspiration og en beregner for statistisk signifikans for at se, om dine tests var sejre, tab eller ikke entydig.

Før A / B-testen

Lad os dække de trin, der skal tages, inden du starter din A / B-test.

1. Vælg en variabel, du vil teste.

Når du optimerer dine websider og e-mails, kan du muligvis finde, at der er et antal variabler, du vil teste. Men for at evaluere, hvor effektiv en ændring er, vil du isolere en “uafhængig variabel” og måle dens ydeevne – ellers kan du ikke være sikker på, hvilken der var ansvarlig for ændringer i ydeevne.

Du kan teste mere end en variabel til en enkelt webside eller e-mail; Bare vær sikker på at du tester dem en ad gangen.

Se på de forskellige elementer i dine marketingressourcer og deres mulige alternativer til design, formulering og layout. Andre ting, du kan teste, inkluderer emnelinjer via e-mail , afsendernavne og forskellige måder at personalisere dine e-mails på.

Husk, at selv enkle ændringer, som at ændre billedet i din e-mail eller ordene på din opfordring til handling-knap, kan skabe store forbedringer Faktisk er disse slags ændringer normalt lettere at måle end de større.

Bemærk: Der er nogle gange, hvor det er mere fornuftigt at teste flere variabler snarere end en enkelt variabel. Dette er en proces kaldet multivariat test. Hvis du spekulerer på, om du skal køre en A / B test versus en multivariat test, her er en nyttig artikel fra Optimizely, der sammenligner de to.

2. Identificer dit mål.

Selvom du vil måle et antal metrics for hver test, skal du vælge en primær metric at fokusere på – inden du ru n testen. Faktisk gør det, før du overhovedet opretter den anden variation. Dette er din “afhængige variabel.”

Tænk over, hvor du vil have denne variabel i slutningen af split-testen. Du kan muligvis angive en officiel hypotese og undersøge dine resultater baseret på denne forudsigelse.

Hvis du venter til bagefter med at overveje, hvilke målinger der er vigtige for dig, hvad dine mål er, og hvordan de ændringer, du foreslår kan påvirke brugeradfærd, så opsætter du muligvis ikke testen på den mest effektive måde.

3. Opret en “kontrol” og en “udfordrer.”

Du har nu din uafhængig variabel, din afhængige variabel og dit ønskede resultat. Brug disse oplysninger til at opsætte den uændrede version af det, du nu tester som din “kontrol”. Hvis du “tester en webside, er dette den uændrede webside, da den allerede findes. Hvis du tester en destinationsside, ville dette være det landingssides design og den kopi, du normalt ville bruge.

Derefter skal du oprette en variation eller en “udfordrer” – webstedet, landingssiden eller e-mailen, du vil teste mod din kontrol. Hvis du f.eks. Spekulerer på, om inkludering af en udtalelse på en destinationsside ville gøre en forskel, skal du oprette din kontrolside uden udtalelser. Opret derefter din variation med en anbefaling.

4. Del din prøvegrupper lige og tilfældigt.

For tests, hvor du har mere kontrol over publikum – som med e-mails – skal du teste med to eller flere målgrupper, der er ens for at få afgørende resultater.

Hvordan du gør dette, vil variere afhængigt af det A / B-testværktøj, du bruger. Hvis du f.eks. er en HubSpot Enterprise-kunde, der gennemfører en A / B-test på en e-mail, vil HubSpot automatisk opdele trafik til dine variationer så hver variation får en tilfældig stikprøve af besøgende.

5. Bestem din stikprøvestørrelse (hvis relevant).

Hvordan du bestemmer din stikprøvestørrelse, vil også variere afhængigt af dit A / B-testværktøj samt typen af A / B-test, du kører.

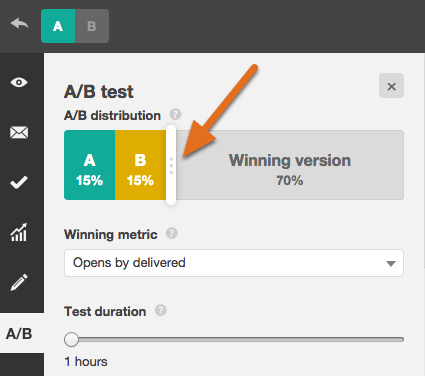

Hvis du A / B tester en e-mail, vil du sandsynligvis sende en A / B-test til en mindre del af din liste for at få statistisk signifikante resultater. Til sidst vælger du en vinder og send den vindende variation videre til resten af listen. (Se “Videnskaben om opdelt test” e-bog i slutningen af denne artikel for mere om beregning af din prøvestørrelse.)

Hvis du er en HubSpot Enterprise-kunde, vil du få hjælp til at bestemme størrelsen. af din prøvegruppe ved hjælp af en skyder. Det giver dig mulighed for at foretage en 50/50 A / B-test af en hvilken som helst stikprøvestørrelse – selvom alle andre prøveopdelinger kræver en liste med mindst 1.000 modtagere.

Hvis du “tester noget, der ikke har et endeligt publikum, f.eks. en webside, så vil hvor længe du holder din test kørende, direkte påvirke din prøve størrelse.

Du bliver nødt til at lade din test køre længe nok til at opnå et betydeligt antal visninger, ellers er det svært at sige, om der var en statistisk signifikant forskel mellem de to variationer.

6. Beslut, hvor betydningsfulde dine resultater skal være.

Når du har valgt din målmåling, skal du overveje, hvor vigtige dine resultater skal være for at retfærdiggøre valg af en variant frem for en anden. Statistisk signifikans er en super vigtig del af A / B-testprocessen, som ofte misforstås. Hvis du har brug for en opdatering af statistisk signifikans ud fra et markedsføringssynspunkt, anbefaler jeg at læse dette blogindlæg.

Jo højere procentdel desto mere sikker kan du være på dine resultater. I de fleste tilfælde vil du have et konfidensniveau på mindst 95% – helst 98% – især hvis det var et tidskrævende eksperiment at oprette. Nogle gange er det dog fornuftigt at bruge en lavere konfidensrate, hvis du ikke har brug for testen for at være så streng.

Matt Rheault, senior software engineer hos HubSpot, kan lide at tænke på statistisk betydning som at placere et væddemål. Hvilke odds har du det godt med at placere et væddemål på? At sige “Jeg” er 80% sikker på, at dette er det rigtige design, og jeg er villig til at satse alt på det “svarer til at køre en A / B-test til 80% betydning og derefter udnævne en vinder.

Rheault siger også, at du sandsynligvis vil have en højere tillidstærskel, når du tester for noget, der kun forbedrer samtalefrekvensen lidt. Hvorfor? Fordi tilfældig variation er mere tilbøjelig til at spille en større rolle.

“Et eksempel, hvor vi kunne føle os sikrere ved at sænke vores tillidstærskel, er et eksperiment, der sandsynligvis vil forbedre konverteringsfrekvensen med 10% eller mere, såsom en redesignet heltesektion,” forklarede han.

“Takeaway her er, at jo mere radikal ændringen er, jo mindre videnskabelig er vi nødt til at være procesmæssige. Jo mere specifik ændringen (knapfarve, mikrokopi osv.), jo mere videnskabelig bør vi være, fordi ændringen mindre sandsynligt har en stor og mærkbar indvirkning på konverteringsfrekvensen. “

7. Sørg for, at du kun kører en test ad gangen på en hvilken som helst kampagne.

Test af mere end én ting for en enkelt kampagne – selvom det ikke er på det samme nøjagtige aktiv – kan komplicere dine resultater. For eksempel, hvis du A / B tester en e-mail-kampagne, der leder til en destinationsside på samme tid, som du A / B tester den pågældende landingsside … hvordan kan du vide, hvilken ændring, der forårsagede stigningen i kundeemner?

Under A / B-testen

Lad os dække de trin, der skal tages under din A / B-test.

8. Brug et A / B-testværktøj.

For at lave en A / B-test på dit websted eller i en e-mail skal du bruge et A / B-testværktøj. Hvis du er en HubSpot Enterprise-kunde, har HubSpot-softwaren funktioner, der lader dig A / B teste e-mails (lær hvordan her), opfordringer til handling (lær hvordan her) og destinationssider (lær hvordan her).

For ikke-HubSpot Enterprise-kunder inkluderer andre muligheder Google Analytics “Eksperimenter, som lader dig A / B teste op til 10 fulde versioner af en enkelt webside og sammenligne deres ydeevne ved hjælp af en tilfældig stikprøve af brugere.

9. Test begge variationer samtidigt.

Timing spiller en væsentlig rolle i resultaterne af din marketingkampagne, uanset om det er tid på dagen, ugedagen eller året i året. Hvis du skulle køre version A i løbet af en måned og version B en måned senere, hvordan ville du vide, om præstationsændringen skyldtes det forskellige design eller den anden måned?

Når du kører A / B-tests, skal du køre to variationer på samme tid, ellers kan du blive ved med at gætte dine resultater.

Den eneste undtagelse her er, hvis du tester selve timing, som at finde de optimale tidspunkter for afsendelse af e-mails. Dette er en god ting at teste, for afhængigt af hvad din virksomhed tilbyder, og hvem dine abonnenter er, kan det optimale tidspunkt for abonnentengagement variere markant efter branche og målmarked.

10. Giv A / B-testen tilstrækkelig tid til at producere nyttige data.

Igen vil du sørge for at lade din test køre længe nok til at opnå en betydelig prøvestørrelse. Ellers er det ” Det vil være svært at fortælle, om der var en statistisk signifikant forskel mellem de to variationer.

Hvor lang tid er lang nok? Afhængigt af din virksomhed, og hvordan du udfører A / B-testen, kan det ske i timer … eller dage … eller uger at få statistisk signifikante resultater. En stor del af, hvor lang tid det tager at få statistisk signifikante resultater, er, hvor meget trafik du får – så hvis din virksomhed ikke får meget trafik til dit websted, vil det tage meget længere tid for dig at køre en A / B test.

I teorien bør du ikke begrænse det tidspunkt, hvor du samler resultater. (Læs dette blogindlæg for at lære mere om stikprøvestørrelse og timing.)

11. Bed om feedback fra rigtige brugere.

A / B-test har meget at gøre med kvantitative data … men det hjælper ikke nødvendigvis dig med at forstå, hvorfor folk tager visse handlinger frem for andre. Mens du er kører din A / B-test, hvorfor ikke indsamle kvalitativ feedback fra rigtige brugere?

En af de bedste måder at bede folk om deres meninger er gennem en undersøgelse eller afstemning. Du kan muligvis tilføje en exitundersøgelse på dit websted, der spørger besøgende, hvorfor de ikke klikkede på en bestemt CTA, eller en på dine takksider, der spørger besøgende, hvorfor de klikkede på en knap eller udfyldte en formular.

Du kan f.eks. finde ud af, at mange mennesker klikkede på en opfordring til handling, der førte dem til en e-bog, men når de først så prisen, konverterede de ikke. Den slags information vil give dig en masse indsigt i, hvorfor dine brugere opfører sig på bestemte måder.

Efter A / B-testen

Lad os endelig dække trinene til tage efter din A / B-test.

12. Fokuser på din målmåling.

Igen, selvom du måler flere målinger, skal du holde dit fokus på den primære målmåling, når du foretager din analyse.

Hvis du f.eks. testede to varianter af en e-mail og valgte kundeemner som din primære metric, skal du ikke blive fanget i åben sats eller klikrate. Du kan muligvis se en høj klikfrekvens og dårlige konverteringsfrekvenser, i hvilket tilfælde du muligvis ender med at vælge den variant, der til sidst havde en lavere klikfrekvens.

13. Mål betydningen af dine resultater ved hjælp af vores A / B-testberegner.

Nu hvor du har bestemt, hvilken variation der fungerer bedst, er det tid til at afgøre, om dine resultater er statistisk signifikante. Er de med andre ord nok til at retfærdiggøre en ændring?

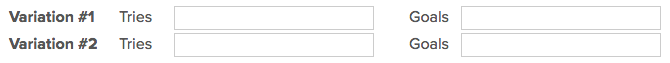

For at finde ud af, skal du udføre en test med statistisk signifikans. Du kan gøre det manuelt … eller du kan bare tilslutte resultater fra dit eksperiment til vores gratis A / B-testberegner.

For hver variant, du testede, bliver du bedt om at indtaste det samlede antal forsøg, som e-mails sendt eller set indtryk. Indtast derefter antallet af mål, det har gennemført – generelt vil du se på klik, men dette kan også være andre typer konverteringer.

Lommeregneren spytter det konfidensniveau, dine data producerer for den vindende variation. Derefter måles dette tal med den værdi, du valgte for at bestemme statistisk signifikans.

14. Tag handling ud fra dine resultater.

Hvis en variation er statistisk bedre end den anden, har du en vinder. Gennemfør din test ved at deaktivere den tabende variation i dit A / B-testværktøj.

Hvis ingen af variationerne er statistisk bedre, har du lige lært, at den variabel, du testede, ikke påvirkede resultaterne, og at du bliver nødt til at markere testen som usikker. I dette tilfælde skal du holde fast ved den oprindelige variation – eller køre en anden test. Du kan bruge de mislykkede data til at hjælpe dig med at finde ud af en ny iteration på din nye test.

Mens A / B-tests hjælper dig med at påvirke resultaterne fra sag til sag, kan du også anvende lektionerne du lærer af hver test og anvender den til fremtidig indsats.

For eksempel, hvis du har gennemført A / B-test i din e-mailmarkedsføring og gentagne gange har fundet ud af, at brug af tal i e-mail-emnelinjer genererer bedre klikfrekvenser , kan du overveje at bruge denne taktik i flere af dine e-mails.

15. Planlæg din næste A / B-test.

Den A / B-test, du lige er færdig, har måske hjulpet du opdager en ny måde at gøre dit marketingindhold mere effektivt – men stop ikke der. Der er altid plads til mere optimering.

Du kan endda prøve at udføre en A / B-test på en anden funktion på den samme webside eller e-mail, du lige har testet. For eksempel, hvis du lige har testet en overskrift på en destinationsside, hvorfor ikke lave en ny test på body copy? Eller farveskema? Eller billeder? Hold altid øje med mulighederne for at øge konverteringsfrekvenser og kundeemner.

Start A / B-test i dag

A / B-test giver dig mulighed for at komme til sandheden om hvilket indhold og marketing dit publikum ønsker at se.Lær, hvordan du bedst udfører nogle af trinnene ovenfor ved hjælp af den gratis e-bog nedenfor.

Redaktørens bemærkning: Dette indlæg blev oprindeligt offentliggjort i maj 2016 og er blevet opdateret med henblik på omfattende.

Oprindeligt offentliggjort 13. april 2020 8:00 : 00, opdateret 8. september 2020

Emner:

A / B-test