Wanneer marketeers zoals wij bestemmingspaginas maken, e-mailteksten schrijven of call-to-action-knoppen ontwerpen, kan dat verleidelijk om onze intuïtie te gebruiken om te voorspellen waardoor mensen klikken en converteren.

Maar marketingbeslissingen baseren op een gevoel kan behoorlijk nadelig zijn voor de resultaten. In plaats van te vertrouwen op gissingen of aannames om deze beslissingen te nemen , kun je veel beter een A / B-test uitvoeren – ook wel een split-test genoemd.

A / B-testen kan waardevol zijn omdat verschillende doelgroepen zich, nou ja, anders gedragen. Iets dat voor het ene bedrijf werkt, hoeft niet per se voor het andere te werken. In feite hebben experts op het gebied van conversiepercentageoptimalisatie (CRO) een hekel aan de term best practices, omdat dit misschien niet de best practice voor u is.

Maar A / B-tests kunnen ook complex zijn. Als u niet oppast, kunt u onjuiste aannames doen over wat mensen leuk vinden en waardoor ze klikken – beslissingen die gemakkelijk andere delen van uw strategie verkeerd kunnen informeren.

Lees verder om te leren hoe u A / B kunt doen. testen voor, tijdens en na het verzamelen van gegevens, zodat u de beste beslissingen kunt nemen op basis van uw resultaten.

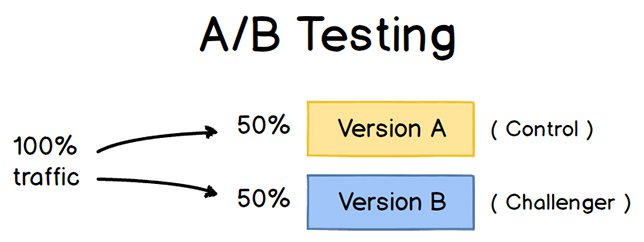

Om een A / B-test uit te voeren, moet u twee verschillende versies van één stuk inhoud maken, met wijzigingen aan een enkele variabele. Vervolgens laat u deze twee versies zien aan twee toehoorders van vergelijkbare grootte en analyseert u welke het beter presteerde gedurende een bepaalde periode (lang genoeg om nauwkeurige conclusies te trekken over uw resultaten).

Bron

A / B-tests helpen marketeers te observeren hoe een versie van een stuk van marketingcontent presteert naast elkaar. Hier zijn twee soorten A / B-tests die u kunt uitvoeren om het conversiepercentage van uw website te verhogen:

Voorbeeld 1: Test voor gebruikerservaring

Misschien wilt u zien of door een bepaalde call-to-action (CTA) -knop naar de bovenkant van uw startpagina te verplaatsen in plaats van deze in de zijbalk te houden, wordt de klikfrequentie verbeterd.

Om deze theorie te testen, kunt u ” d een andere, alternatieve webpagina te maken die de wijziging van de CTA-plaatsing weerspiegelde. Het bestaande ontwerp – of de “controle” – is versie A. Versie B is de “uitdager”. Vervolgens kunt u deze twee versies testen door ze allemaal te laten zien aan een vooraf bepaald percentage sitebezoekers. Idealiter is het percentage bezoekers dat beide versies ziet hetzelfde.

Leer hoe u eenvoudig A / B-testen onderdeel van uw website met HubSpots Marketing Hub.

Voorbeeld 2: ontwerptest

Misschien wilt u weten of u de kleur van uw call-to-action (CTA ) -knop kan de klikfrequentie verhogen.

Om deze theorie A / B te testen, zou u een alternatieve CTA-knop ontwerpen met een andere knopkleur die naar dezelfde bestemmingspagina leidt als het besturingselement. u gebruikt meestal een rode call-to-action-knop in uw marketingcontent, en de groene variant ontvangt meer klikken na uw A / B-test, dit kan het waard zijn om vanaf nu de standaardkleur van uw call-to-action-knoppen in groen te veranderen .

Download hier onze gratis inleidende gids voor meer informatie over A / B-testen.

De voordelen van A / B-testen

A / B-testen heeft een veelvoud aan voordelen voor een ma rketing team, afhankelijk van wat u besluit te testen. Maar bovenal zijn deze tests waardevol voor een bedrijf omdat ze “goedkoop zijn, maar een hoge beloning opleveren.

Stel dat u een maker van inhoud in dienst heeft met een salaris van $ 50.000 / jaar. Deze contentmaker publiceert vijf artikelen per week voor de bedrijfsblog, in totaal 260 artikelen per jaar. Als de gemiddelde post op de blog van het bedrijf 10 leads genereert, zou je kunnen zeggen dat het iets meer dan $ 192 kost om 10 leads voor het bedrijf te genereren ($ 50.000 salaris ÷ 260 artikelen = $ 192 per artikel). Dat is een flinke brok verandering.

Als je deze maker van inhoud nu vraagt om twee dagen te besteden aan het ontwikkelen van een A / B-test voor één artikel, in plaats van in die periode twee artikelen te schrijven, zou je $ 192 kunnen verbranden omdat je één artikel minder publiceert . Maar als uit die A / B-test blijkt dat u de conversieratio van elk artikel kunt verhogen van 10 naar 20 leads, heeft u zojuist $ 192 uitgegeven om mogelijk het aantal klanten dat uw bedrijf via uw blog krijgt te verdubbelen.

Als de test slaagt niet, je bent natuurlijk $ 192 kwijtgeraakt – maar nu kun je je volgende A / B-test nog hoger opgeleid maken. Als die tweede test erin slaagt de conversieratio van je blog te verdubbelen, heb je uiteindelijk $ 284 uitgegeven om mogelijk de inkomsten van je bedrijf te verdubbelen. Het maakt niet uit hoe vaak uw A / B-test mislukt, het uiteindelijke succes zal bijna altijd opwegen tegen de kosten om deze uit te voeren.

De complete A / B-testkit voor marketeers

Vul dit formulier in om uw kit te krijgen.

Er zijn veel soorten split-tests die u kunt uitvoeren om het experiment uiteindelijk de moeite waard te maken.Hier zijn enkele gemeenschappelijke doelen die marketeers voor hun bedrijf hebben bij A / B-testen:

- Meer websiteverkeer: het testen van verschillende blogposts of webpagina-titels kan het aantal mensen wijzigen dat op die hyperlinktitel klikt naar ga naar uw website. Hierdoor kan het websiteverkeer toenemen.

- Hogere conversieratio: door verschillende locaties, kleuren of zelfs ankertekst op uw CTAs te testen, kan het aantal mensen dat op deze CTAs klikt om naar een bestemmingspagina te gaan, veranderen. Hierdoor kan het aantal mensen toenemen dat formulieren op uw website invult, hun contactgegevens naar u verzendt en converteren in een lead.

- Lagere bouncepercentage: als uw websitebezoekers vertrekken (of “) snel na het bezoeken van uw website, kan het testen van verschillende introducties van blogposts, lettertypen of functieafbeeldingen dit bouncepercentage verminderen en meer bezoekers vasthouden.

- Minder verlaten winkelwagen: e-commercebedrijven ontvangen 40% – 75% van de klanten volgens MightyCall hun website verlaten met items in hun winkelwagentje. Dit staat bekend als verlaten van het winkelwagentje. Het testen van verschillende productfotos, het ontwerpen van uitcheckpaginas en zelfs waar verzendkosten worden weergegeven, kan dit verlatingspercentage verlagen.

Laten we nu eens kijken naar de checklist voor het opzetten, uitvoeren, en het meten van een A / B-test.

Hoe A / B-testen uit te voeren

Volg mee met onze gratis A / B-testkit met alles wat u nodig hebt om A / B-tests uit te voeren, inclusief een testtrackingsjabloon, een handleiding voor instructies en inspiratie en een statistische significantiecalculator om te zien of uw tests zijn gewonnen, verloren of niet overtuigend.

Voor de A / B-test

Laten we de stappen bespreken die moeten worden genomen voordat u met uw A / B-test begint.

1. Kies een variabele om te testen.

Terwijl u uw webpaginas en e-mails optimaliseert, zou u kunnen ontdekken dat er een aantal variabelen zijn die u wilt testen. Maar om te evalueren hoe effectief een wijziging is, “wil je één” onafhankelijke variabele “isoleren en de prestaties ervan meten – anders weet je” niet welke verantwoordelijk was voor wijzigingen in de prestaties.

U kan meer dan één variabele testen voor een enkele webpagina of e-mail; zorg ervoor dat u ze een voor een test.

Bekijk de verschillende elementen in uw marketingbronnen en hun mogelijke alternatieven voor ontwerp, formulering en lay-out. Andere dingen die u zou kunnen testen, zijn onder meer e-mailonderwerpregels , afzendernamen en verschillende manieren om uw e-mails te personaliseren.

Houd er rekening mee dat zelfs eenvoudige wijzigingen, zoals het wijzigen van de afbeelding in uw e-mail of de woorden op uw call-to-action-knop, grote verbeteringen kunnen opleveren . In feite zijn dit soort wijzigingen meestal gemakkelijker te meten dan de grotere.

Opmerking: soms is het logischer om meerdere variabelen te testen in plaats van een enkele variabele. Dit is een proces genaamd multivariate testen. Als u zich afvraagt of u een A / B-test moet uitvoeren in plaats van een multivariate test, vindt u hier een nuttig artikel van Optimizely waarin de twee worden vergeleken.

2. Bepaal uw doel.

Hoewel u voor elke test een aantal statistieken meet, kiest u een primaire statistiek waarop u zich wilt concentreren – voordat u begint n de test. Doe het in feite voordat u de tweede variant instelt. Dit is uw “afhankelijke variabele”.

Bedenk waar u deze variabele wilt hebben aan het einde van de split-test. U kunt een officiële hypothese stellen en uw resultaten onderzoeken op basis van deze voorspelling.

Als u daarna wacht om na te denken over welke statistieken belangrijk voor u zijn, wat uw doelen zijn en hoe de veranderingen die u voorstelt kan het gebruikersgedrag beïnvloeden, dan zou je de test misschien niet op de meest effectieve manier kunnen opzetten.

3. Creëer een “control” en een “challenger”.

Je hebt nu je onafhankelijke variabele, uw afhankelijke variabele en uw gewenste resultaat. Gebruik deze informatie om de ongewijzigde versie van wat u “test” in te stellen als uw “controle”. Als u een webpagina test, is dit de ongewijzigde webpagina zoals deze al bestaat. Als u een bestemmingspagina test, is dit het ontwerp en de kopie van de bestemmingspagina die u normaal zou gebruiken.

Bouw van daaruit een variant of een “uitdager”: de website, bestemmingspagina of e-mail die u aan uw controle wilt testen. Als u zich bijvoorbeeld afvraagt of het toevoegen van een testimonial op een bestemmingspagina een verschil zou maken, stel dan uw controlepagina in zonder testimonials. Maak vervolgens uw variant met een testimonial.

4. Splits uw steekproefgroepen gelijkelijk en willekeurig.

Voor tests waarbij u meer controle heeft over het publiek, zoals bij e-mails, moet u testen met twee of meer gelijkwaardige doelgroepen om tot definitieve resultaten te komen.

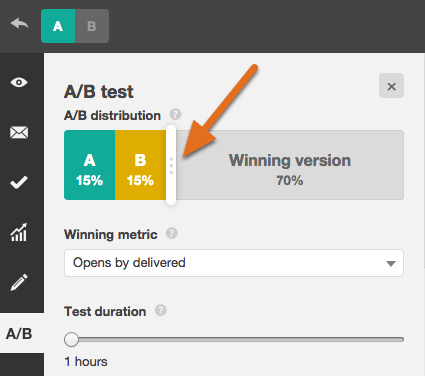

Hoe u dit doet, hangt af van de A / B-testtool die u gebruikt. Als u een HubSpot Enterprise-klant bent die bijvoorbeeld een A / B-test uitvoert op een e-mail, zal HubSpot automatisch het verkeer naar uw varianten splitsen. zodat elke variant een willekeurige steekproef van bezoekers krijgt.

5. Bepaal uw steekproefomvang (indien van toepassing).

Hoe u uw steekproefomvang bepaalt, hangt ook af van uw A / B-testtool en het type A / B-test dat u uitvoert.

Als u een e-mail A / B test, wilt u waarschijnlijk een A / B-test naar een kleiner gedeelte van uw lijst sturen om statistisch significante resultaten te krijgen. Uiteindelijk zult u een winnaar kiezen en stuur de winnende variant door naar de rest van de lijst. (Zie het e-boek “The Science of Split Testing” aan het einde van dit artikel voor meer informatie over het berekenen van uw steekproefomvang.)

Als u een HubSpot Enterprise-klant bent, heeft u wat hulp bij het bepalen van de grootte van uw voorbeeldgroep met behulp van een schuifregelaar. Hiermee kunt u een 50/50 A / B-test van elke steekproefomvang doen, hoewel voor alle andere steekproefsplitsingen een lijst van ten minste 1000 ontvangers nodig is.

Als u “iets test dat geen eindig publiek heeft, zoals een webpagina, heeft dit rechtstreeks invloed op uw steekproefomvang.

U moet uw test lang genoeg laten lopen om een aanzienlijk aantal views te krijgen, anders is het moeilijk te zeggen of er een statistisch significant verschil was tussen de twee variaties.

6. Bepaal hoe significant uw resultaten moeten zijn.

Als u eenmaal uw doelstatistiek heeft gekozen, bedenk dan hoe belangrijk uw resultaten moeten zijn om te rechtvaardigen dat u de ene variant boven de andere kiest. Statistische significantie is een superbelangrijk onderdeel van het A / B-testproces dat vaak verkeerd wordt begrepen. Als u een opfriscursus wilt over statistische significantie vanuit marketingoogpunt, raad ik u aan deze blogpost te lezen.

Hoe hoger het percentage van uw betrouwbaarheidsniveau, hoe zekerder u kunt zijn van uw resultaten. In de meeste gevallen wilt u een betrouwbaarheidsniveau van minimaal 95% – bij voorkeur zelfs 98% – vooral als het een tijdrovend experiment was om op te zetten. Soms is het echter logisch om een lager betrouwbaarheidspercentage te gebruiken als de test niet zo streng hoeft te zijn.

Matt Rheault, een senior software-engineer bij HubSpot, denkt graag aan statistische significantie zoals het plaatsen van een weddenschap. Op welke kansen vind je het prettig om een weddenschap af te sluiten? Zeggen “Ik” ben 80% zeker dat dit het juiste ontwerp is en ik “ben bereid er alles op te wedden” is vergelijkbaar met het uitvoeren van een A / B-test voor 80% significantie en vervolgens een winnaar uitroepen.

Rheault zegt ook dat je waarschijnlijk een hogere vertrouwensdrempel wilt als je test op iets dat de conversieratio slechts lichtjes verbetert. Waarom? Omdat willekeurige variantie waarschijnlijk een grotere rol speelt.

“Een voorbeeld waarbij we ons veiliger zouden kunnen voelen door onze vertrouwensdrempel te verlagen, is een experiment dat de conversieratio waarschijnlijk met 10% of meer zal verbeteren, zoals een opnieuw ontworpen heldengedeelte”, legt hij uit.

“Het punt hier is dat hoe radicaler de verandering, hoe minder wetenschappelijk we procesmatig moeten zijn. Hoe specifieker de verandering (knopkleur, microkopie, enz.), hoe meer wetenschappelijk we zouden moeten zijn, omdat de verandering waarschijnlijk geen grote en merkbare invloed heeft op de conversieratio. “

7. Zorg ervoor dat u voor een campagne slechts één test tegelijk uitvoert.

Het testen van meer dan één ding voor één campagne – zelfs als het niet exact hetzelfde item betreft – kan uw resultaten bemoeilijken. Als u bijvoorbeeld een e-mailcampagne A / B-test die naar een bestemmingspagina leidt, op hetzelfde moment dat u die bestemmingspagina A / B-test … hoe kunt u dan weten welke wijziging de toename van het aantal leads heeft veroorzaakt?

Tijdens de A / B-test

Laten we de stappen bespreken die u tijdens uw A / B-test moet nemen.

8. Gebruik een A / B-testtool.

Om een A / B-test op uw website of in een e-mail te doen, heeft u een A / B-testtool nodig. Als u een HubSpot Enterprise-klant bent, heeft de HubSpot-software functies waarmee u A / B-test-e-mails (lees hier hoe u dit doet), call-to-action (lees hier hoe u dit doet) en landingspaginas (lees hier hoe u dit doet).

Voor niet-HubSpot Enterprise-klanten zijn er andere opties: Google Analytics “Experiments, waarmee je tot 10 volledige versies van een enkele webpagina A / B kunt testen en hun prestaties kunt vergelijken met een willekeurige steekproef van gebruikers.

9. Test beide varianten tegelijkertijd.

Timing speelt een belangrijke rol in de resultaten van uw marketingcampagne, of het nu gaat om het tijdstip, de dag van de week of de maand van het jaar. Als u versie A zou gebruiken tijdens een maand en versie B een maand later, hoe zou u dan weten of de prestatieverandering werd veroorzaakt door het andere ontwerp of door de andere maand?

Als u A / B-tests uitvoert, moet u de twee varianten tegelijk, anders zou u uw resultaten kunnen twijfelen.

De enige uitzondering hierop is als u de timing zelf test, zoals het vinden van de optimale tijden voor het verzenden van e-mails. Dit is een goede zaak om te testen, want afhankelijk van wat uw bedrijf te bieden heeft en wie uw abonnees zijn, kan de optimale tijd voor het betrekken van abonnees aanzienlijk verschillen per branche en doelmarkt.

10. Geef de A / B-test voldoende tijd om bruikbare gegevens te produceren.

Nogmaals, u “wilt ervoor zorgen dat u uw test lang genoeg laat lopen om een substantiële steekproefomvang te krijgen. Anders moet het” Het is moeilijk te zeggen of er een statistisch significant verschil was tussen de twee varianten.

Hoe lang is lang genoeg? Afhankelijk van uw bedrijf en hoe u de A / B-test uitvoert, kan het verkrijgen van statistisch significante resultaten binnen enkele uren … of dagen … of weken gebeuren. Een groot deel van hoe lang het duurt om statistisch significante resultaten te krijgen, is hoeveel verkeer u ontvangt. Dus als uw bedrijf niet veel verkeer naar uw website krijgt, duurt het veel langer voordat u een A / B test.

In theorie zou u de tijd waarin u resultaten verzamelt niet moeten beperken. (Lees deze blogpost voor meer informatie over steekproefomvang en timing.)

11. Vraag om feedback van echte gebruikers.

A / B-tests hebben veel te maken met kwantitatieve gegevens … maar dat helpt u niet per se te begrijpen waarom mensen bepaalde acties ondernemen in plaats van anderen. Als u uw A / B-test uitvoert, waarom verzamelt u dan geen kwalitatieve feedback van echte gebruikers?

Een van de beste manieren om mensen om hun mening te vragen, is door middel van een enquête of peiling. U kunt een exit-enquête op uw site toevoegen die bezoekers vraagt waarom ze niet op een bepaalde CTA hebben geklikt, of een enquête op uw bedankpaginas waarin bezoekers wordt gevraagd waarom ze op een knop hebben geklikt of een formulier hebben ingevuld.

Je zou bijvoorbeeld kunnen ontdekken dat veel mensen op een call-to-action hebben geklikt die hen naar een e-boek leidde, maar toen ze de prijs zagen, converteren ze niet. Dat soort informatie geeft u veel inzicht in waarom uw gebruikers zich op bepaalde manieren gedragen.

Na de A / B-test

Laten we tot slot de stappen bespreken om afnemen na uw A / B-test.

12. Concentreer u op uw doelstatistiek.

Nogmaals, hoewel u meerdere statistieken meet, moet u zich concentreren op die primaire doelstatistiek wanneer jij doet je analyse.

Als je bijvoorbeeld twee varianten van een e-mail hebt getest en leads als je primaire statistiek hebt gekozen, raak dan niet verstrikt in de open rate of klikfrequentie. Mogelijk ziet u een hoge klikfrequentie en lage conversiepercentages, in welk geval u uiteindelijk de variant kiest met een lagere klikfrequentie.

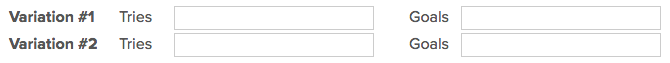

13. Meet de significantie van uw resultaten met behulp van onze A / B-testcalculator.

Nu u “hebt bepaald welke variant het beste presteert, is het tijd om te bepalen of uw resultaten statistisch significant zijn of niet. Met andere woorden, volstaan ze om een wijziging te rechtvaardigen?

Om erachter te komen, moet u een statistische significantietest uitvoeren. U kunt dat handmatig doen … of u kunt gewoon de resultaten van uw experiment naar onze gratis rekenmachine voor A / B-testen.

Voor elke variant die u hebt getest, wordt u gevraagd het totale aantal pogingen in te voeren, zoals verzonden e-mails of geziene vertoningen. Geef vervolgens het aantal behaalde doelen op. Meestal kijk je naar klikken, maar dit kunnen ook andere typen conversies zijn.

De rekenmachine spuugt het betrouwbaarheidsniveau uit dat uw gegevens produceren voor de winnende variant. Meet vervolgens dat getal af tegen de waarde die u hebt gekozen om de statistische significantie te bepalen.

14. Onderneem actie op basis van uw resultaten.

Als de ene variant statistisch gezien beter is dan de andere, heeft u een winnaar. Voltooi uw test door de verliezende variant uit te schakelen in uw A / B-testtool.

Als geen van beide varianten statistisch gezien beter is, heb je zojuist “vernomen dat de variabele die je hebt getest geen invloed had op de resultaten, en moet je de test als niet overtuigend markeren. Blijf in dit geval bij de originele variant – of voer een nieuwe test uit. U kunt de mislukte gegevens gebruiken om een nieuwe iteratie voor uw nieuwe test te vinden.

Hoewel A / B-tests u helpen om de resultaten van geval tot geval te beïnvloeden, kunt u de lessen ook toepassen u leert van elke test en past deze toe op toekomstige inspanningen.

Als u bijvoorbeeld “A / B-tests in uw e-mailmarketing heeft uitgevoerd en herhaaldelijk hebt vastgesteld dat het gebruik van getallen in onderwerpregels van e-mails leidt tot betere klikfrequenties , zou je kunnen overwegen om die tactiek in meer van je e-mails te gebruiken.

15. Plan je volgende A / B-test.

De A / B-test die je net hebt voltooid, heeft misschien geholpen u ontdekt een nieuwe manier om uw marketinginhoud effectiever te maken, maar daar blijft het niet bij. Er is altijd ruimte voor meer optimalisatie.

U kunt zelfs proberen een A / B-test uit te voeren op een ander kenmerk van dezelfde webpagina of e-mail waarop u net een test hebt gedaan. Als u bijvoorbeeld net een kop op een bestemmingspagina heeft getest, waarom zou u dan geen nieuwe test doen op de body-copy? Of kleurenschema? Of afbeeldingen? Houd altijd de mogelijkheden in de gaten om conversieratios en leads te verhogen.

Start vandaag nog met A / B-tests

Met A / B-tests kunt u achterhalen welke inhoud en marketing uw publiek wil zien.Leer hoe u enkele van de bovenstaande stappen het beste kunt uitvoeren met behulp van het gratis e-boek hieronder.

Opmerking van de redacteur: dit bericht is oorspronkelijk gepubliceerd in mei 2016 en is volledig bijgewerkt.

Oorspronkelijk gepubliceerd op 13 april 2020 8:00 : 00 AM, bijgewerkt op 8 september 2020

Onderwerpen:

A / B-testen