Når markedsførere som oss lager landingssider, skriver e-postkopier eller designer oppfordringsknapper, kan det være fristende å bruke vår intuisjon til å forutsi hva som får folk til å klikke og konvertere.

Men å basere markedsføringsbeslutninger ut fra en «følelse» kan være ganske skadelig for resultatene. I stedet for å stole på gjetninger eller antagelser for å ta disse beslutningene , det er mye bedre å kjøre en A / B-test – noen ganger kalt en delt test.

A / B-testing kan være verdifullt fordi forskjellige målgrupper oppfører seg, vel, annerledes. Noe som fungerer for ett selskap, fungerer ikke nødvendigvis for et annet. Faktisk hater eksperter på konverteringsfrekvensoptimalisering (CRO) begrepet «best practices» fordi det faktisk ikke er den beste fremgangsmåten for deg.

Men A / B-tester kan også være kompliserte. Hvis du ikke er forsiktig, kan du gjøre feil antagelser om hva folk liker og hva som får dem til å klikke – avgjørelser som lett kan misinformere andre deler av strategien din.

Fortsett å lese for å lære hvordan du gjør A / B testing før, under og etter datainnsamling, slik at du kan ta de beste avgjørelsene fra resultatene dine.

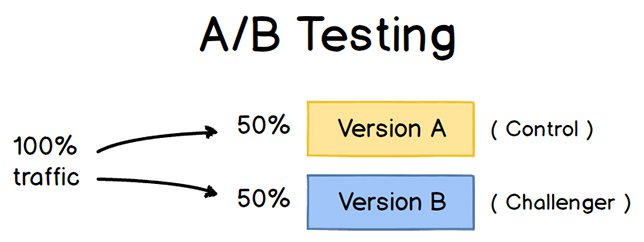

For å kjøre en A / B-test må du lage to forskjellige versjoner av ett innhold, med endringer til en enkelt variabel. Deretter vil du vise disse to versjonene for to målgrupper av samme størrelse og analysere hvilken som presterte bedre over en bestemt tidsperiode (lenge nok til å treffe nøyaktige konklusjoner om resultatene).

Kilde

A / B-testing hjelper markedsførere med å observere hvordan en versjon av et stykke markedsføringsinnhold fungerer sammen med et annet. Her er to typer A / B-tester du kan gjennomføre i et forsøk på å øke nettstedets konverteringsfrekvens:

Eksempel 1: Brukeropplevelsestest

Kanskje du vil se om å flytte en bestemt oppfordringsknapp (CTA) til toppen av hjemmesiden din i stedet for å holde den i sidefeltet vil forbedre klikkfrekvensen.

For å A / B teste denne teorien, du » d lage en annen, alternativ webside som gjenspeiler endringen av CTA-plassering. Det eksisterende designet – eller «kontrollen» – er versjon A. Versjon B er «utfordreren.» Deretter vil du teste disse to versjonene ved å vise hver av dem for en forhåndsbestemt prosentandel av besøkende på nettstedet. Ideelt sett er prosentandelen av besøkende som ser begge versjonene den samme.

Lær hvordan du enkelt A / B-test en komponent på nettstedet ditt med HubSpots Marketing Hub.

Eksempel 2: Designtest

Kanskje du vil finne ut om du endrer fargen på handlingsfremmende oppfordring (CTA ) -knappen kan øke klikkfrekvensen.

For å A / B teste denne teorien, ville du utforme en alternativ CTA-knapp med en annen knappefarge som fører til samme destinasjonsside som kontrollen. du bruker vanligvis en rød oppfordringsknapp i markedsføringsinnholdet ditt, og den grønne varianten mottar flere klikk etter A / B-testen din, dette kan fortjene å endre standardfargen på oppfordringsknappene dine til grønt fra nå av .

For å lære mer om A / B-testing, last ned vår gratis introduksjonsveiledning her.

Fordelene med A / B-testing

A / B-testing har en rekke fordeler for en mor avhengig av hva det er du bestemmer deg for å teste. Men fremfor alt er disse testene verdifulle for en bedrift fordi de har lave kostnader, men høye belønninger.

La oss si at du ansetter en innholdsskaper med en lønn på $ 50 000 per år. Denne innholdsskaperen publiserer fem artikler per uke for selskapets blogg, til sammen 260 artikler per år. Hvis det gjennomsnittlige innlegget på selskapets blogg genererer 10 potensielle kunder, kan du si at det koster litt over $ 192 å generere 10 potensielle kunder for virksomheten ($ 50 000 lønn ÷ 260 artikler = $ 192 per artikkel). Det er en solid del av endringen.

Hvis du ber denne innholdsskaperen om å bruke to dager på å utvikle en A / B-test på en artikkel, i stedet for å skrive to artikler i den perioden, kan du forbrenne $ 192 fordi du publiserer en artikkel færre . Men hvis A / B-testen finner ut at du kan øke konverteringsfrekvensen til hver artikkel fra 10 til 20 potensielle kunder, brukte du bare $ 192 til å potensielt doble antall kunder bedriften får fra bloggen din.

Hvis testen mislykkes, selvfølgelig, du tapte $ 192 – men nå kan du gjøre din neste A / B-test enda mer utdannet. Hvis den andre testen lykkes med å doble bloggens konverteringsfrekvens, brukte du til slutt $ 284 for å potensielt doble selskapets inntekter. Uansett hvor mange ganger A / B-testen din mislykkes, vil den endelige suksessen nesten alltid oppveie kostnadene for å gjennomføre den.

Komplett A / B-testsett for markedsførere

Fyll ut dette skjemaet for å få settet ditt.

Det er mange typer splittester du kan kjøre for å gjøre eksperimentet verdt det til slutt.Her er noen vanlige mål markedsførere har for sin virksomhet når A / B-testing:

- Økt trafikk på nettstedet: Å teste forskjellige blogginnlegg eller nettsidetitler kan endre antall personer som klikker på den hyperkoblede tittelen til komme til nettstedet ditt. Dette kan øke trafikken på nettstedet som et resultat.

- Høyere konverteringsfrekvens: Å teste forskjellige steder, farger eller til og med ankertekst på CTA-ene dine kan endre antall personer som klikker på disse CTA-ene for å komme til en destinasjonsside. Dette kan øke antallet personer som fyller ut skjemaer på nettstedet ditt, sender kontaktinformasjonen til deg og «konvertere» til et potensial.

- Lavere fluktfrekvens: Hvis besøkende på nettstedet ditt forlater (eller «spretter «) raskt etter å ha besøkt nettstedet ditt, kan du teste forskjellige introduksjoner, skrifter eller funksjonsbilder av blogginnlegg redusere denne avvisningsfrekvensen og beholde flere besøkende.

- Nedre handlekurvavbrudd: E-handelsbedrifter ser 40% – 75% av kundene la nettstedet deres stå med varer i handlekurven, ifølge MightyCall. Dette er kjent som «forlat handlekurv.» Å teste forskjellige produktbilder, utsjekkingsdesign og til og med hvor fraktkostnader vises, kan redusere denne nedleggelsesgraden.

La oss nå gå gjennom sjekklisten for å sette opp, kjøre, og måle en A / B-test.

Hvordan gjennomføre A / B-testing

Følg med med vårt gratis A / B-testsett med alt du trenger for å kjøre A / B-testing, inkludert en testsporingsmal, en veiledning for instruksjon og inspirasjon og en kalkulator for statistisk signifikans for å se om testene dine var gevinster, tap eller ikke avgjørende.

Før A / B-testen

La oss dekke trinnene du må ta før du starter A / B-testen.

1. Velg en variabel for å teste.

Når du optimaliserer nettsidene og e-postene dine, kan det hende du finner ut at det er flere variabler du vil teste. Men for å evaluere hvor effektiv en endring er, vil du isolere en «uavhengig variabel» og måle ytelsen – ellers kan du ikke være sikker på hvilken som var ansvarlig for endringer i ytelsen.

Du kan teste mer enn én variabel for en enkelt webside eller e-post; bare vær sikker på at du tester dem en om gangen.

Se på de ulike elementene i markedsføringsressursene dine og deres mulige alternativer for design, formulering og layout. Andre ting du kan teste inkluderer emnelinjer via e-post , avsendernavn og forskjellige måter å tilpasse e-postene dine på.

Husk at selv enkle endringer, som å endre bildet i e-posten din eller ordene på handlings-knappen, kan føre til store forbedringer . Faktisk er slike endringer vanligvis lettere å måle enn de større.

Merk: Det er noen ganger det er mer fornuftig å teste flere variabler i stedet for en enkelt variabel. Dette er en prosess kalles multivariat testing. Hvis du lurer på om du skal kjøre en A / B-test kontra en multivariat test, her «er en nyttig artikkel fra Optimizely som sammenligner de to.

2. Identifiser målet ditt.

Selv om du vil måle et antall beregninger for hver test, velg en primær beregning å fokusere på – før du ru n testen. Faktisk, gjør det før du selv setter opp den andre varianten. Dette er din «avhengige variabel.»

Tenk på hvor du vil at denne variabelen skal være på slutten av deltesten. Du kan angi en offisiell hypotese og undersøke resultatene dine basert på denne spådommen.

Hvis du venter til etterpå med å tenke på hvilke beregninger som er viktige for deg, hva dine mål er og hvordan endringene du foreslår kan påvirke brukeratferd, så kan det hende du ikke setter opp testen på den mest effektive måten.

3. Lag en «kontroll» og en «utfordrer.»

Du har nå din uavhengig variabel, din avhengige variabel og ønsket resultat. Bruk denne informasjonen til å sette opp den uendrede versjonen av hva du tester som «kontroll». Hvis du tester en webside, er dette den uendrede nettsiden slik den allerede eksisterer. Hvis du tester en destinasjonsside, vil dette være destinasjonssidesignet og kopien du vanligvis bruker.

Derfra kan du lage en variant eller en «utfordrer» – nettstedet, destinasjonssiden eller e-postmeldingen du vil teste mot din kontroll. Hvis du for eksempel lurer på om å inkludere en attest på en destinasjonsside vil gjøre en forskjell, kan du sette opp kontrollsiden din uten attester. Opprett deretter din variant med en attest.

4. Del din prøvegrupper likt og tilfeldig.

For tester der du har mer kontroll over publikum – som med e-post – må du teste med to eller flere målgrupper som er like for å få avgjørende resultater.

Hvordan du gjør dette vil variere avhengig av A / B-testverktøyet du bruker. Hvis du for eksempel er en HubSpot Enterprise-kunde som gjennomfører en A / B-test på en e-post, vil HubSpot automatisk dele trafikken til dine variasjoner slik at hver variant får et tilfeldig utvalg av besøkende.

5. Bestem prøvestørrelsen din (hvis aktuelt).

Hvordan du bestemmer prøvestørrelsen din, vil også variere avhengig av A / B-testverktøyet ditt, samt typen A / B-test du kjører.

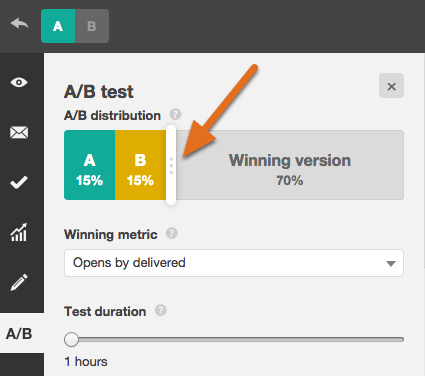

Hvis du A / B tester en e-post, vil du sannsynligvis sende en A / B-test til en mindre del av listen din for å få statistisk signifikante resultater. Til slutt vil du velge en vinner og send vinnervariasjonen videre til resten av listen. (Se «The Science of Split Testing» eBok på slutten av denne artikkelen for mer om beregning av prøvestørrelsen.)

Hvis du er en HubSpot Enterprise-kunde, vil du ha litt hjelp til å bestemme størrelsen. av prøvegruppen din ved hjelp av en glidebryter. Den lar deg gjøre en 50/50 A / B-test av en hvilken som helst prøvestørrelse – selv om alle andre prøvesplittinger krever en liste med minst 1000 mottakere.

Hvis du tester noe som ikke har et begrenset publikum, som en webside, vil hvor lenge du holder testen i gang direkte påvirke prøvestørrelse.

Du må la testen kjøre lenge nok til å få et betydelig antall visninger, ellers vil det være vanskelig å si om det var en statistisk signifikant forskjell mellom de to variantene.

6. Bestem hvor viktige resultatene dine må være.

Når du har valgt målberegningen, kan du tenke på hvor viktige resultatene dine må være for å rettferdiggjøre valg av en variant fremfor en annen. Statistisk signifikans er en super viktig del av A / B-testprosessen som ofte misforstås. Hvis du trenger en oppdatering av statistisk signifikans fra et markedsføringssynspunkt, anbefaler jeg å lese dette blogginnlegget.

Jo høyere prosentandel desto mer sikker kan du være om resultatene dine. I de fleste tilfeller vil du ha et konfidensnivå på minst 95% – helst til og med 98% – spesielt hvis det var et tidskrevende eksperiment å sette opp. Noen ganger er det imidlertid fornuftig å bruke en lavere konfidensrate hvis du ikke trenger testen for å være så streng.

Matt Rheault, senior programvareingeniør i HubSpot, liker å tenke på statistisk betydning som å plassere et spill. Hvilke odds er du komfortable med å satse på? Å si «Jeg» er 80% sikker på at dette er riktig design, og jeg er villig til å satse alt på det «ligner på å kjøre en A / B-test til 80% betydning og deretter kåre en vinner.

Rheault sier også at du sannsynligvis vil ha en høyere tillitsterskel når du tester for noe som bare forbedrer samtalefrekvensen litt. Hvorfor? Fordi tilfeldig avvik er mer sannsynlig å spille en større rolle.

«Et eksempel der vi kan føle oss tryggere ved å senke tillitsterskelen vår er et eksperiment som sannsynligvis vil forbedre konverteringsfrekvensen med 10% eller mer, for eksempel en redesignet helteseksjon,» forklarte han.

«Takeaway her er at jo mer radikal endringen er, jo mindre vitenskapelig trenger vi å være prosessvis. Jo mer spesifikk endringen (knappefarge, mikrokopi osv.), jo mer vitenskapelig bør vi være fordi endringen er mindre sannsynlig å ha stor og merkbar innvirkning på konverteringsfrekvensen. «

7. Forsikre deg om at du bare kjører én test om gangen på en hvilken som helst kampanje.

Å teste mer enn én ting for en enkelt kampanje – selv om den ikke er på samme eksakte ressurs – kan komplisere resultatene dine. Hvis du for eksempel A / B tester en e-postkampanje som leder til en destinasjonsside samtidig som du A / B tester den destinasjonssiden … hvordan kan du vite hvilken endring som forårsaket økningen i potensielle kunder?

Under A / B-testen

La oss dekke trinnene du må ta under A / B-testen.

8. Bruk et A / B-testverktøy.

For å gjøre en A / B-test på nettstedet ditt eller i en e-post, må du bruke et A / B-testverktøy. Hvis du er en HubSpot Enterprise-kunde, har HubSpot-programvaren funksjoner som lar deg A / B teste e-post (lære hvordan her), oppfordring til handling (lære hvordan her) og destinasjonssider (lære hvordan her).

For ikke-HubSpot Enterprise-kunder inkluderer andre alternativer Google Analytics «Eksperimenter, som lar deg A / B teste opptil 10 komplette versjoner av en enkelt webside og sammenligne ytelsen ved hjelp av et tilfeldig utvalg av brukere.

9. Test begge variasjonene samtidig.

Timing spiller en viktig rolle i markedsføringskampanjens resultater, enten det er tid på dagen, ukedagen eller måneden i året. Hvis du skulle kjøre versjon A i løpet av en måned og versjon B en måned senere, hvordan ville du vite om ytelsesendringen var forårsaket av en annen utforming eller en annen måned?

Når du kjører A / B-tester, må du kjøre to varianter samtidig, ellers kan du la deg gjette resultatene.

Det eneste unntaket her er hvis du tester selve tidspunktet, som å finne de optimale tidspunktene for sending av e-post. Dette er en flott ting å teste, avhengig av hva bedriften din tilbyr og hvem abonnentene dine er, kan den optimale tiden for abonnentengasjement variere betydelig etter bransje og målmarked.

10. Gi A / B-testen nok tid til å produsere nyttige data.

Igjen vil du sørge for at du lar testen kjøre lenge nok til å oppnå en betydelig utvalgstørrelse. Ellers er det » Det vil være vanskelig å se om det var en statistisk signifikant forskjell mellom de to variasjonene.

Hvor lang er lang nok? Avhengig av firmaet ditt og hvordan du utfører A / B-testen, kan det å få statistisk signifikante resultater skje i løpet av timer … eller dager … eller uker. En stor del av hvor lang tid det tar å få statistisk signifikante resultater, er hvor mye trafikk du får – så hvis virksomheten din ikke får mye trafikk til nettstedet ditt, vil det ta mye lengre tid før du driver en A / B test.

I teorien bør du ikke begrense tiden du samler inn resultater. (Les dette blogginnlegget for å lære mer om prøvestørrelse og timing.)

11. Be om tilbakemelding fra ekte brukere.

A / B-testing har mye å gjøre med kvantitative data … men det vil ikke nødvendigvis hjelpe deg å forstå hvorfor folk tar visse handlinger fremfor andre. Mens du er kjører A / B-testen din, hvorfor ikke samle inn kvalitativ tilbakemelding fra virkelige brukere?

En av de beste måtene å be folk om deres meninger er gjennom en undersøkelse eller avstemning. Du kan legge til en avslutningsundersøkelse på nettstedet ditt som spør besøkende hvorfor de ikke klikket på en bestemt CTA, eller en på takkesidene dine som spør besøkende om hvorfor de klikket på en knapp eller fylte ut et skjema.

Du kan for eksempel oppdage at mange klikket på en oppfordring til handling som førte dem til en eBok, men når de så prisen, konverterte de ikke. Den slags informasjon vil gi deg mye innsikt i hvorfor brukerne dine oppfører seg på bestemte måter.

Etter A / B-testen

La oss til slutt dekke trinnene for å ta etter A / B-testen.

12. Fokuser på målberegningen.

Igjen, selv om du måler flere beregninger, må du holde fokus på den primære målverdien når du gjør analysen din.

Hvis du for eksempel testet to varianter av en e-post og valgte potensielle kunder som din primære beregning, ikke bli fanget av åpen hastighet eller klikkfrekvens. Det kan hende du ser en høy klikkfrekvens og dårlige konverteringsfrekvenser, i så fall kan du ende opp med å velge variasjonen som til slutt hadde en lavere klikkfrekvens.

13. Mål betydningen av resultatene dine ved hjelp av A / B-testkalkulatoren.

Nå som du har bestemt deg for hvilken variasjon som fungerer best, er det på tide å avgjøre om resultatene dine er statistisk signifikante. Er det med andre ord nok til å rettferdiggjøre en endring?

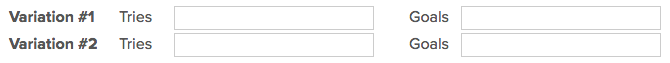

For å finne ut av det, må du utføre en test av statistisk signifikans. Du kan gjøre det manuelt … eller du kan bare koble til resultater fra eksperimentet ditt til vår gratis A / B-testkalkulator.

For hver variant du testet, vil du bli bedt om å legge inn totalt antall forsøk, som sendte e-postmeldinger eller visninger. Angi deretter antall mål den fullførte – generelt vil du se på klikk, men dette kan også være andre typer konverteringer.

Kalkulatoren vil spytte ut konfidensnivået dataene dine gir for den vinnende variasjonen. Mål deretter tallet mot verdien du valgte for å bestemme statistisk signifikans.

14. Ta grep ut fra resultatene dine.

Hvis en variant er statistisk bedre enn den andre, har du en vinner. Gjør testen ved å deaktivere den tapte variasjonen i A / B-testverktøyet.

Hvis ingen av variasjonene er statistisk bedre, har du nettopp lært at variabelen du testet ikke hadde noen innvirkning på resultatene, og du må markere testen som usikker. I dette tilfellet, hold deg til den opprinnelige variasjonen – eller kjør en ny test. Du kan bruke de mislykkede dataene for å hjelpe deg med å finne ut en ny iterasjon på den nye testen din.

Mens A / B-tester hjelper deg med å påvirke resultatene fra sak til sak, kan du også bruke leksjonene du lærer av hver test og bruker den på fremtidig innsats.

For eksempel hvis du har gjennomført A / B-tester i e-postmarkedsføringen din og gjentatte ganger har funnet ut at bruk av tall i emnelinjer for e-post genererer bedre klikkfrekvenser , kan det være lurt å vurdere å bruke denne taktikken i flere av e-postene dine.

15. Planlegg din neste A / B-test.

A / B-testen du nettopp fullførte, kan ha hjulpet du oppdager en ny måte å gjøre markedsføringsinnholdet ditt mer effektivt – men ikke stopp der. Det er alltid rom for mer optimalisering.

Du kan til og med prøve å gjennomføre en A / B-test på en annen funksjon på samme nettside eller e-post du nettopp testet. For eksempel, hvis du nettopp har testet en overskrift på en destinasjonsside, hvorfor ikke gjøre en ny test på kroppskopi? Eller fargevalg? Eller bilder? Hold alltid øye med muligheter for å øke konverteringsfrekvenser og potensielle kunder.

Start A / B-testing i dag

A / B-testing lar deg komme til sannheten om hvilket innhold og markedsføring publikum ønsker å se.Lær hvordan du best utfører noen av trinnene ovenfor ved hjelp av den gratis e-boken nedenfor.

Redaktørens merknad: Dette innlegget ble opprinnelig publisert i mai 2016 og er oppdatert for å være omfattende.

Opprinnelig publisert 13. april 2020 8:00 : 00.00, oppdatert 8. september 2020

Temaer:

A / B-testing