Lorsque des spécialistes du marketing comme nous créent des pages de destination, rédigent des e-mails ou conçoivent des boutons d’incitation à l’action, cela peut être tentant dutiliser notre intuition pour prédire ce qui incitera les gens à cliquer et à convertir.

Mais baser les décisions marketing sur un « sentiment » peut être assez préjudiciable aux résultats. Plutôt que de se fier à des suppositions ou à des hypothèses pour prendre ces décisions , il est préférable d’exécuter un test A / B – parfois appelé test fractionné.

Test A / B peut être utile parce que différents publics se comportent, bien, différemment. Quelque chose qui fonctionne pour une entreprise ne fonctionne pas nécessairement pour une autre. En fait, les experts en optimisation du taux de conversion (CRO) détestent le terme «meilleures pratiques» car ce nest peut-être pas la meilleure pratique pour vous.

Mais les tests A / B peuvent aussi être complexes. Si vous ne faites pas attention, vous pourriez faire des hypothèses erronées sur ce que les gens aiment et ce qui les fait cliquer – des décisions qui pourraient facilement fausser d’autres parties de votre stratégie.

Continuez à lire pour savoir comment faire du A / B des tests avant, pendant et après la collecte de données afin que vous puissiez prendre les meilleures décisions à partir de vos résultats.

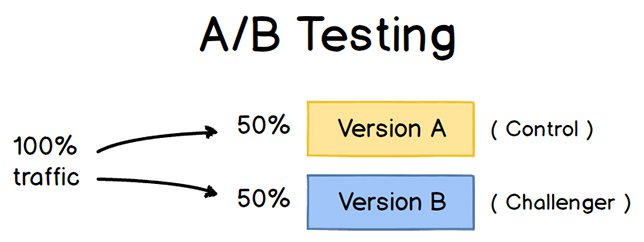

Pour exécuter un test A / B, vous devez créer deux versions différentes dun élément de contenu, avec des modifications à une seule variable. Ensuite, vous allez montrer ces deux versions à deux audiences de taille similaire et analyser celle qui a le mieux fonctionné sur une période donnée (suffisamment longue pour tirer des conclusions précises sur vos résultats).

Source

Les tests A / B aident les spécialistes du marketing à observer comment une version dun élément de le contenu marketing fonctionne parallèlement à un autre. Voici deux types de tests A / B que vous pourriez effectuer pour augmenter le taux de conversion de votre site Web:

Exemple 1: Test d’expérience utilisateur

Vous voulez peut-être voir si déplacer un certain bouton dappel à laction (CTA) en haut de votre page daccueil au lieu de le conserver dans la barre latérale améliorera son taux de clics.

Pour tester A / B cette théorie, vous » d créer une autre page Web alternative reflétant ce changement de placement CTA. La conception existante – ou le «contrôle» – est la version A. La version B est le «challenger». Ensuite, vous « d testeriez ces deux versions en montrant chacune delles à un pourcentage prédéterminé de visiteurs du site. Idéalement, le pourcentage de visiteurs qui voient lune ou lautre version est le même.

Découvrez comment effectuer facilement un test A / B un composant de votre site Web avec Hub Marketing HubSpot.

Exemple 2: Design Test

Peut-être voulez-vous savoir si vous changez la couleur de votre appel à laction (CTA ) peut augmenter son taux de clics.

Pour tester A / B cette théorie, vous « d concevez un bouton CTA alternatif avec une couleur de bouton différente qui mène à la même page de destination que le contrôle. Si vous utilisez généralement un bouton dappel à laction rouge dans votre contenu marketing, et la variante verte reçoit plus de clics après votre test A / B, cela pourrait mériter de changer la couleur par défaut de vos boutons dappel à laction en vert à partir de maintenant .

Pour en savoir plus sur les tests A / B, téléchargez notre guide dintroduction gratuit ici.

Les avantages des tests A / B

Les tests A / B ont une multitude davantages pour un ma équipe de marketing, en fonction de ce que vous décidez de tester. Mais surtout, ces tests sont précieux pour une entreprise car ils « sont peu coûteux mais très rémunérateurs.

Supposons que vous employiez un créateur de contenu avec un salaire de 50 000 $ / an. Ce créateur de contenu publie cinq articles par semaine pour le blog de lentreprise, totalisant 260 articles par an. Si la publication moyenne sur le blog de lentreprise génère 10 prospects, vous pouvez dire quil en coûte un peu plus de 192 USD pour générer 10 prospects pour lentreprise (50 000 USD de salaire ÷ 260 articles = 192 USD par article). Cest « un gros morceau de changement.

Désormais, si vous demandez à ce créateur de contenu de passer deux jours à développer un test A / B sur un article, au lieu d’écrire deux articles au cours de cette période, vous risquez de perdre 192 $ car vous publiez un article de moins . Mais si ce test A / B révèle que vous pouvez augmenter le taux de conversion de chaque article de 10 à 20 prospects, vous venez de dépenser 192 USD pour potentiellement doubler le nombre de clients que votre entreprise obtient de votre blog.

Si le test échoue, bien sûr, vous avez perdu 192 $ – mais maintenant vous pouvez rendre votre prochain test A / B encore plus instruit. Si ce deuxième test réussit à doubler le taux de conversion de votre blog, vous avez finalement dépensé 284 $ pour potentiellement doubler les revenus de votre entreprise. Quel que soit le nombre déchecs de votre test A / B, son succès éventuel lemportera presque toujours sur le coût de son exécution.

Le kit de test A / B complet pour les spécialistes du marketing

Remplissez ce formulaire pour obtenir votre kit.

Il existe de nombreux types de tests fractionnés que vous pouvez exécuter pour que lexpérience en vaille la peine à la fin.Voici quelques objectifs communs que les spécialistes du marketing ont pour leur entreprise lors des tests A / B:

- Augmentation du trafic sur le site Web: le test de différents titres de blog ou de page Web peut changer le nombre de personnes qui cliquent sur ce lien hypertexte en accédez à votre site Web. Cela peut augmenter le trafic sur le site Web.

- Taux de conversion plus élevé: tester différents emplacements, couleurs ou même ancrer du texte sur vos CTA peut modifier le nombre de personnes qui cliquent sur ces CTA pour accéder à une page de destination. Cela peut augmenter le nombre de personnes qui remplissent des formulaires sur votre site Web, vous soumettent leurs coordonnées et se « convertissent » en prospect.

- Taux de rebond inférieur: si les visiteurs de votre site Web quittent (ou « rebondissent » « ) rapidement après avoir visité votre site Web, tester différentes introductions darticles de blog, polices ou images de caractéristiques peut réduire ce taux de rebond et fidéliser davantage de visiteurs.

- Abandon du panier: les entreprises de commerce électronique voient entre 40% et 75% des clients quitter leur site Web avec des articles dans leur panier, selon MightyCall. Cest ce quon appelle «labandon du panier». Tester différentes photos de produits, concevoir des pages de paiement et même lorsque les frais de livraison sont affichés peut réduire ce taux dabandon.

Maintenant, parcourons la liste de contrôle pour la configuration, lexécution, et mesurer un test A / B.

Comment effectuer un test A / B

Suivez-nous avec notre kit de test A / B gratuit avec tout ce dont vous avez besoin pour exécuter des tests A / B, y compris un modèle de suivi des tests, un guide pratique pour les instructions et linspiration, et un calculateur de signification statistique pour voir si vos tests ont été des gains, des pertes ou peu concluants.

Avant le test A / B

Découvrons les étapes à suivre avant de commencer votre test A / B.

1. Choisissez une variable à tester.

Au fur et à mesure que vous optimisez vos pages Web et vos e-mails, vous trouverez peut-être un certain nombre de variables que vous souhaitez tester. Mais pour évaluer lefficacité dun changement, vous voudrez isoler une « variable indépendante » et mesurer ses performances – sinon, vous ne pouvez pas être sûr de celle qui est responsable des changements de performances.

Vous peut tester plus dune variable pour une seule page Web ou e-mail; assurez-vous simplement de les tester un par un.

Examinez les différents éléments de vos ressources marketing et leurs alternatives possibles pour la conception, le libellé et la mise en page. Vous pouvez également tester les lignes dobjet des e-mails. , les noms des expéditeurs et différentes façons de personnaliser vos e-mails.

Gardez à lesprit que même des changements simples, comme changer limage de votre e-mail ou les mots de votre bouton dappel à laction, peuvent entraîner de grandes améliorations . En fait, ces types de changements sont généralement plus faciles à mesurer que les plus importants.

Remarque: Il est parfois plus judicieux de tester plusieurs variables plutôt quune seule. Cest un processus appelé test multivarié. Si vous « vous demandez si vous devriez exécuter un test A / B par rapport à un test multivarié, voici » un article utile dOptimizely qui compare les deux.

2. Identifiez votre objectif.

Bien que vous mesuriez un certain nombre de métriques pour chaque test, choisissez une métrique principale sur laquelle vous concentrer – avant de ru n le test. En fait, faites-le avant même de configurer la deuxième variante. Ceci est votre « variable dépendante ».

Pensez à lendroit où vous voulez que cette variable se trouve à la fin du test de fractionnement. Vous pouvez énoncer une hypothèse officielle et examiner vos résultats en fonction de cette prédiction.

Si vous attendez plus tard pour réfléchir aux métriques importantes pour vous, quels sont vos objectifs et comment les changements que vous proposez peut affecter le comportement de lutilisateur, alors vous risquez de ne pas configurer le test de la manière la plus efficace.

3. Créez un « contrôle » et un « challenger ».

Vous avez maintenant votre variable indépendante, votre variable dépendante et le résultat souhaité. Utilisez ces informations pour configurer la version non modifiée de ce que vous « testez » comme « contrôle ». Si vous testez une page Web, il sagit de la page Web non modifiée telle quelle existe déjà. Si vous testez une page de destination, il sagira de la conception et de la copie de page de destination que vous utiliseriez normalement.

À partir de là, créez une variante ou un « challenger » – le site Web, la page de destination ou le-mail que vous testerez par rapport à votre contrôle. Par exemple, si vous « vous demandez si inclure un témoignage sur une page de destination ferait une différence, configurez votre page de contrôle sans témoignages. Ensuite, créez votre variante avec un témoignage.

4. Divisez votre échantillons de groupes de manière égale et aléatoire.

Pour les tests où vous avez plus de contrôle sur laudience – comme avec les e-mails – vous devez tester avec deux ou plusieurs audiences égales afin dobtenir des résultats concluants.

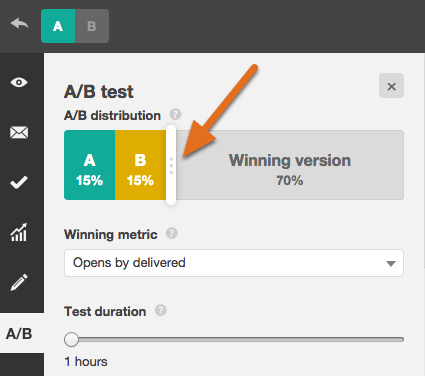

La façon dont vous procédez varie en fonction de loutil de test A / B que vous utilisez. Si vous « êtes un client HubSpot Enterprise effectuant un test A / B sur un e-mail, par exemple, HubSpot répartira automatiquement le trafic vers vos variantes. afin que chaque variante reçoive un échantillon aléatoire de visiteurs.

5. Déterminez la taille de votre échantillon (le cas échéant).

La façon dont vous déterminez la taille de votre échantillon variera également en fonction de votre outil de test A / B, ainsi que du type de test A / B que vous « exécutez.

Si vous testez A / B un e-mail, vous voudrez probablement envoyer un test A / B à une plus petite partie de votre liste pour obtenir des résultats statistiquement significatifs. Finalement, vous choisirez un gagnant et envoyez la variante gagnante au reste de la liste. (Pour en savoir plus sur le calcul de la taille de votre échantillon, reportez-vous à lebook « La science du test fractionné » à la fin de cet article.)

Si vous « êtes un client HubSpot Enterprise, vous » aurez de laide pour déterminer la taille de votre groupe déchantillons à laide dun curseur. Il « vous permettra de faire un test 50/50 A / B de nimporte quelle taille déchantillon – bien que toutes les autres divisions déchantillons nécessitent une liste dau moins 1 000 destinataires.

Si vous « testez quelque chose qui na pas daudience limitée, comme une page Web, la durée pendant laquelle vous continuez à exécuter votre test affectera directement votre taille de léchantillon.

Vous devrez laisser votre test sexécuter suffisamment longtemps pour obtenir un nombre substantiel de vues, sinon il sera difficile de dire sil y avait une différence statistiquement significative entre les deux variantes.

6. Décidez de limportance de vos résultats.

Une fois que vous avez choisi la métrique de votre objectif, réfléchissez à limportance de vos résultats pour justifier le choix dune variante par rapport à une autre. La signification statistique est une partie très importante du processus de test A / B qui est souvent mal comprise. Si vous avez besoin dun rappel sur la signification statistique dun point de vue marketing, je vous recommande de lire ce billet de blog.

Plus le pourcentage est élevé. de votre niveau de confiance, plus vous serez sûr de vos résultats. Dans la plupart des cas, vous souhaiterez un niveau de confiance de 95% minimum – de préférence même 98% – surtout sil sagissait dune expérience longue à mettre en place. Cependant, il est parfois judicieux dutiliser un taux de confiance plus faible si vous navez pas besoin que le test soit aussi strict.

Matt Rheault, ingénieur logiciel senior chez HubSpot, aime penser à la signification statistique comme le placement un pari. Sur quelle cote êtes-vous à laise pour parier? Dire « Je » suis sûr à 80% que cest le bon design et que je « suis prêt à tout miser dessus » équivaut à exécuter un test A / B à 80% de signification puis déclarer un gagnant.

Rheault dit également que vous voudrez probablement un seuil de confiance plus élevé lorsque vous testez quelque chose qui naméliore que légèrement le taux de conversation. Pourquoi? Parce que la variance aléatoire est plus susceptible de jouer un rôle plus important.

« Un exemple où nous pourrions nous sentir plus en sécurité en abaissant notre seuil de confiance est une expérience qui améliorera probablement le taux de conversion de 10% ou plus, comme une nouvelle section des héros », a-t-il expliqué.

« Ce quil faut retenir ici, cest que plus le changement est radical, moins nous devons être scientifiques en termes de processus. Plus le changement (couleur du bouton, micro copie, etc.), plus nous devrions être scientifiques, car le changement est moins susceptible davoir un impact important et notable sur le taux de conversion. «

7. Assurez-vous de neffectuer quun seul test à la fois sur une campagne.

Tester plusieurs éléments pour une seule campagne, même si ce nest pas sur le même élément, peut compliquer vos résultats. Par exemple, si vous testez A / B une campagne de-mails qui dirige vers une page de destination en même temps que vous testez A / B cette page de destination … comment savoir quel changement a provoqué laugmentation des prospects?

Pendant le test A / B

Découvrons les étapes à suivre pendant votre test A / B.

8. Utilisez un outil de test A / B.

Pour faire un test A / B sur votre site Web ou dans un e-mail, vous devrez utiliser un outil de test A / B. Si vous « êtes un client HubSpot Enterprise, le logiciel HubSpot dispose de fonctionnalités qui vous permettent de tester A / B les e-mails (découvrez comment faire ici), les appels à laction (découvrez comment ici) et les pages de destination (découvrez comment ici).

Pour les clients non-HubSpot Enterprise, dautres options incluent Google Analytics « Experiments, qui vous permet de tester A / B jusquà 10 versions complètes dune seule page Web et de comparer leurs performances à laide dun échantillon aléatoire dutilisateurs.

9. Testez les deux variantes simultanément.

Le timing joue un rôle important dans les résultats de votre campagne marketing, que ce soit lheure, le jour de la semaine ou le mois de lannée. Si vous exécutez la version A pendant un mois et la version B un mois plus tard, comment sauriez-vous si le changement de performance a été causé par la conception différente ou par le mois différent?

Lorsque vous exécutez des tests A / B, vous devrez exécuter le deux variantes en même temps, sinon vous risquez de devoir douter de vos résultats.

La seule exception ici est si vous testez le timing lui-même, comme trouver les moments optimaux pour envoyer des e-mails. Cest une bonne chose à tester car en fonction de ce que propose votre entreprise et de vos abonnés, le moment optimal pour lengagement des abonnés peut varier considérablement selon le secteur et le marché cible.

10. Donnez au test A / B suffisamment de temps pour produire des données utiles.

Encore une fois, vous « voudrez vous assurer de laisser votre test sexécuter suffisamment longtemps pour obtenir une taille déchantillon substantielle. Sinon, » ll sera difficile de dire sil y avait une différence statistiquement significative entre les deux variantes.

Combien de temps est-il suffisant? Selon votre entreprise et la façon dont vous exécutez le test A / B, lobtention de résultats statistiquement significatifs peut se produire en quelques heures … ou jours … ou semaines. Le trafic généré dépend en grande partie du temps nécessaire pour obtenir des résultats statistiquement significatifs. Par conséquent, si votre entreprise nobtient pas beaucoup de trafic vers votre site Web, il vous faudra beaucoup plus de temps pour exécuter un A / B test.

En théorie, vous ne devriez pas limiter le temps pendant lequel vous collectez les résultats. (Lisez cet article de blog pour en savoir plus sur la taille et le calendrier des échantillons.)

11. Demandez lavis dutilisateurs réels.

Les tests A / B ont beaucoup à voir avec des données quantitatives … mais cela ne vous aidera pas nécessairement à comprendre pourquoi les gens prennent certaines mesures par rapport à dautres. En exécutant votre test A / B, pourquoi ne pas recueillir des commentaires qualitatifs auprès de vrais utilisateurs?

Lune des meilleures façons de demander aux gens leur opinion est de réaliser une enquête ou un sondage. Vous pouvez ajouter une enquête de sortie sur votre site qui demande aux visiteurs pourquoi ils nont pas cliqué sur un certain CTA, ou une enquête sur vos pages de remerciement qui demande aux visiteurs pourquoi ils ont cliqué sur un bouton ou rempli un formulaire.

Vous pourriez constater, par exemple, que beaucoup de gens ont cliqué sur un appel à laction les menant à un ebook, mais une fois quils ont vu le prix, ils nont pas converti. Ce type d’informations vous donnera de nombreuses informations sur les raisons pour lesquelles vos utilisateurs se comportent de certaines manières.

Après le test A / B

Enfin, voyons les étapes à suivre pour après votre test A / B.

12. Concentrez-vous sur la métrique de votre objectif.

Encore une fois, même si vous mesurerez plusieurs métriques, concentrez-vous sur cette métrique dobjectif principal lorsque vous faites votre analyse.

Par exemple, si vous avez testé deux variantes dun e-mail et que vous avez choisi les prospects comme mesure principale, ne vous laissez pas surprendre par le taux douverture ou le taux de clics. Vous constaterez peut-être un taux de clics élevé et des taux de conversion faibles, auquel cas vous pourriez finir par choisir la variante qui a finalement eu un taux de clics inférieur.

13. Mesurez la signification de vos résultats à laide de notre calculateur de tests A / B.

Maintenant que vous avez déterminé quelle variation est la plus performante, il est temps de déterminer si vos résultats sont statistiquement significatifs ou non. En dautres termes, sont-ils suffisants pour justifier un changement?

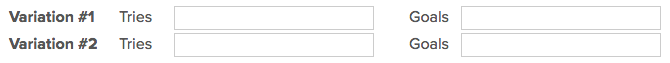

Pour le savoir, vous devrez effectuer un test de signification statistique. Vous pouvez le faire manuellement … ou vous pouvez simplement brancher le résultats de votre test à notre calculateur de tests A / B gratuit.

Pour chaque variante que vous avez testée, vous serez invité à saisir le nombre total dessais, comme les e-mails envoyés ou les impressions vues. Ensuite, saisissez le nombre dobjectifs atteints. En général, vous examinerez les clics, mais il peut également sagir dautres types de conversions.

La calculatrice crachera le niveau de confiance que vos données produisent pour la variante gagnante. Ensuite, mesurez ce nombre par rapport à la valeur que vous avez choisie pour déterminer la signification statistique.

14. Agissez en fonction de vos résultats.

Si une variante est statistiquement meilleure que lautre, vous avez un gagnant. Terminez votre test en désactivant la variante perdante dans votre outil de test A / B.

Si aucune des deux variantes nest statistiquement meilleure, vous venez dapprendre que la variable que vous avez testée na pas eu dincidence sur les résultats, et vous devrez marquer le test comme non concluant. Dans ce cas, tenez-vous-en à la variante dorigine ou effectuez un autre test. Vous pouvez utiliser les données ayant échoué pour vous aider à trouver une nouvelle itération sur votre nouveau test.

Bien que les tests A / B vous aident à influencer les résultats au cas par cas, vous pouvez également appliquer les leçons vous apprenez de chaque test et vous lappliquez à vos efforts futurs.

Par exemple, si vous avez effectué des tests A / B dans votre marketing par e-mail et que vous avez constaté à plusieurs reprises que lutilisation de nombres dans les lignes dobjet des e-mails génère de meilleurs taux de clics , vous pouvez envisager dutiliser cette tactique dans plus de vos e-mails.

15. Planifiez votre prochain test A / B.

Le test A / B que vous venez de terminer peut avoir aidé vous découvrez une nouvelle façon de rendre votre contenu marketing plus efficace – mais ne vous arrêtez pas là. Il y a toujours de la place pour plus doptimisation.

Vous pouvez même essayer deffectuer un test A / B sur une autre fonctionnalité de la même page Web ou de le-mail que vous venez de tester. Par exemple, si vous venez de tester un titre sur une page de destination, pourquoi ne pas faire un nouveau test sur la copie du corps? Ou une palette de couleurs? Ou des images? Gardez toujours un œil sur les opportunités daugmenter les taux de conversion et les prospects.

Commencer les tests A / B dès aujourdhui

Les tests A / B vous permettent de découvrir la vérité sur le contenu et le marketing votre public veut voir.Apprenez à réaliser au mieux certaines des étapes ci-dessus en utilisant le livre électronique gratuit ci-dessous.

Note de léditeur: Cet article a été publié à lorigine en mai 2016 et a été mis à jour pour être complet.

Publié à lorigine le 13 avril 2020 8:00 : 00 AM, mis à jour le 8 septembre 2020

Sujets:

A / B Testing